Ceci n’est pas une fable. L’eau avait débordé à Valence quand en novembre 2024 à Evian s’est tenue la journée consacrée aux liens qui l’unissent à l’espace. Qu’est-ce que l’on voit de l’eau depuis le satellite, en quoi cela peut-il nous aider à la mieux gérer ? Une manière d’explorer les outils que chercheurs, techniciens et élus ont à leur disposition pour améliorer leur manière de comprendre, de connaître et de prévoir la vie de l’eau que le changement climatique perturbe depuis déjà une génération. Un colloque organisé au Palais Lumière d’Evian les Bains par Bertrand Cousin et son équipe du Cluster eau lémanique.

Photos et vidéos © FD, sauf mentions contraires.

Il faut des sous et du terrain

Dans son introduction, Claude Haegi, Président de la Fondation – suisse – pour le développement durable des régions d’Europe (FEDRE) et Vice-président du Cluster Eau Lémanique organisateur de l’événement prévint d’emblée : « La montagne s’affaiblit ! » Elle s’érode, s’écoule, s’effondre. Elle descend dans les vallées, entraînée par le changement climatique. « Malgré les avertissements réitérés depuis longtemps, », a-t-il dit puis écrit dans un billet sur le réseau LinkedIn, « la fragilisation des espaces naturels, l’effondrement de parois rocheuses dans les vallées montagneuses, des terrains mouvants jusqu’en plaine et en sites urbains s’ouvrant à des flots d’eau et de boue, la fonte spectaculaire des glaciers aux multiples conséquences, » la science avait prévenu, les faits sont là. « On n’avait pas imaginé que des cours d’eau qui étaient tranquilles jusqu’à présent puissent se transformer en menaces considérables. L’eau est sans doute une des menaces les plus grandes, » et c’est tout l’intérêt, conclut-il, de structures telles que le Cluster Eau Lémanique et la Commission internationale de la protection des eaux du Léman (Cipel) de le rappeler et le démontrer sans cesse aux élus et à leurs administrés à l’échelle transfrontalière.

Que faire ? « Améliorer le lien qu’il y a entre la gestion de l’eau sur les territoires et l’aménagement du territoire, » défend Bruno Faurel, membre du comité de bassin Rhône-Méditerranée-Corse et président du syndicat d’aménagement de l’Arve et de ses affluents. L’eau n’est toujours pas un élément structurant de l’aménagement du territoire. Elle est toujours considérée comme une ressource, alors que « nos forêts, notre agriculture, notre biodiversité ont aussi besoin d’eau ! ». Or, très peu de documents d’urbanisme et de planification tiennent compte de cette universalité de l’eau. « Rares sont les schémas de cohérence territoriaux (Scot) qui abordent l’eau sous un autre regard que le simple regard de la ressource, », prend-il pour exemple. Avant d’aborder deux sujets qui fâchent : d’abord lrse/e financement de l’eau, aujourd’hui basée sur la seule consommation. « Est-ce de cette manière-là qu’on arrivera à intégrer l’idée que le soin apporté à l’eau, c’est le soin apporté à la nature dans son entier, c’est le soin apporté à notre avenir et à notre qualité de vie ? » La réponse est dans la question. La taxe Gémapi (Gestion des milieux aquatiques et prévention des inondations) a apporté un début de changement en faisant financer la protection… contre les débordements de l’eau par un. pourcentage sur la taxe foncière qui est prélevée par les collectivités. Autre sujet, celui de la gouvernance. Selon Bruno Faurel, l’eau se travaille au ras du terrain, au plus proche du territoire. Autrement dit, pas seulement à celle des six grands bassins-versants inscrits dans la loi de 1964 (voir plus bas). « Il est essentiel que l’échelon territorial puisse se saisir de cette question […] à travers des organisations particulières. Je pense que nous devons songer à couvrir la totalité du territoire français par des commissions locales de l’eau [CLE], qui permettent une démocratie de l’eau, mais aussi à travers des regroupements de collectivités en établissements publics territoriaux de bassins [EPTB], qui sont de véritables objets administratifs, démocratiques, qui ont une capacité d’action décuplée par l’investissement des élus de proximité sur ces sujets. »

Une bonne gouvernance soixantenaire

L’eau, c‘est avant tout une « gouvernance », autrement dit une manière de gouverner. En France, elle est plutôt bonne. Le système mis en place par la loi de 1964 a montré ses mérites, au point d’être exporté. Un petit rappel historique s’impose pour savoir de quoi on parle quand on aborde le sujet de « gouvernance. »

Plus ou moins inspirée de ce que faisaient déjà Allemands et Hollandais, cette loi fondamentale a fait le ménage dans le foutoir des textes qui prétendaient jusque-là organiser l’administration de l’eau et faire baisser sa pollution. Elle a mis en place les agences de l’eau, une par bassin-versant (enfin, presque, car il fallait qu’à la tête de chacune pût être nommé un ingénieur d’un des grands corps de l’État !). Alors uniques au monde, les agences de l’eau françaises ont un peu révolutionné la manière d’administrer en France et ailleurs car leurs aires d’actions, les bassins hydrographiques, se substituent aux frontières administratives. Autre révolution à l’époque, la création des redevances, ces taxes assises sur la facture d’eau de chacun de nous en vertu d’un principe écolo, le fameux « pollueur-payeur » – tu pollues, tu paies à hauteur de ce que tu pollues ; et d’un autre, plus basique, plus tu consommes, plus tu dépenses.

Vingt-huit ans plus tard, la loi de 1992 a introduit un principe essentiel : l’eau est considérée comme un bien commun de la nation. Cette loi a introduit également l’autorisation du Préfet pour tout projet susceptible d’altérer la qualité de l’eau, et instauré les schémas directeurs d’aménagement et de gestion de l’eau (SDAGE) – des outils de planification, un par agence, déclinés au niveau des sous-bassins (ceux des affluents des fleuves) en Schémas d’aménagement et de gestion de l’eau (SAGE). Les Sage sont mis en œuvre par les Commissions locales de l’eau, les CLE, qui sont des parlements d’usagers et d’élus où l’on parle d’eau et surtout, du territoire de vie.

En 2006, la loi sur l’eau et les milieux aquatiques (LEMA) a poussé un peu plus loin le cran de la « démocratie de l’eau » en imposant que chacun de nous doive bénéficier d’une quantité minimale d’eau dans des conditions économiquement acceptables. La LEMA a aussi introduit dans le droit la hiérarchie des besoins sur laquelle les préfets s’appuient en cas de restrictions liées à la sécheresse (L’eau pour les hommes, l’eau pour les bêtes, l’eau pour la nature et, s’il en reste, pour les cultures et les usines). Cela dit, la LEMA est en partie la transposition de la directive-cadre européenne sur l’eau de l’année… 2000 qui fixe un objectif de retour au bon état des eaux, lequel n’est toujours pas atteint. Pas plus que les taux de nitrates dans certaines de nos rivières, qui sont encore assez hauts pour que les plages se couvrent d’algues vertes et que l’Europe fasse payer à la France des amendes pour irrespect de sa directive nitrates votée en… 1991.

La Suisse, la France et la Cipel : une gestion internationale de l’eau

La France est un bon exemple qui s’exporte mais s’arrête aux frontières. Le système se substitue uniquement aux frontières administratives nationales. Or, le Léman est franco-suisse. La limite est au milieu, on la traverse en bateau. Entre Evian et Lausanne, qui gère l’eau ? La Commission internationale de la protection des eaux du Léman, la Cipel. Nicole Gallina en est la secrétaire générale : « c’est une organisation intergouvernementale qui a été créée il y a soixante ans parce que les eaux du lac étaient alors insalubres. 10 000 km2 sur 5 territoires, 3 suisses, 2 français, » cantons et départements réunis par la Cipel en compagnie des agences de l’eau, de la Dreal et des préfectures. « Nous avons un rôle de coordination entre les différents territoires, mais pas uniquement, car la Cipel fait aussi des recommandations, efficaces car elles ont amené, par exemple, à [développer les unités de] déphosphatation des stations d’épuration. » Ce qui a fait disparaître les explosions démographiques d’algues vertes dans le lac-frontière.

En cette fin d’année 2024, la Cipel a fait une nouvelle recommandation sur une menace de taille différente, la moule quagga, qui, bien aidée par le changement climatique, a envahi les hauts-fonds du Léman. « On fait de la sensibilisation auprès des propriétaires de bateaux, on leur dit par exemple de bien les laver, et on demande aux autorités concernées de regarder à une obligation en la matière. » La moule est là, l’essentiel aujourd’hui est de limiter sa dispersion.

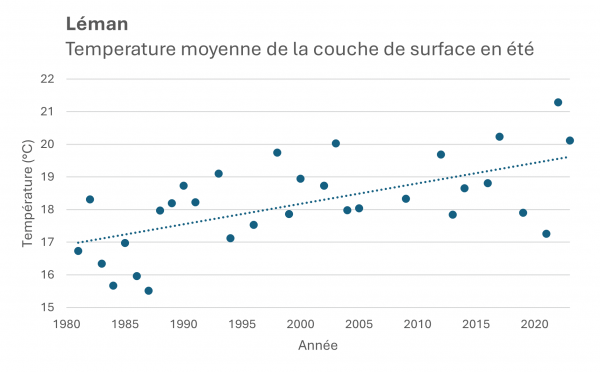

Mais aussi, de surveiller la température. Les eaux du lac se réchauffent, alors, elles se mélangent moins bien. Le Léman a besoin de froid pour qu’en hiver, une stratification s’y installe : une couche d’eau supérieure froide, dessous l’essentiel un peu plus chaud, et le fond, toujours à 4 °C (c’est à cette température que l’eau est la plus dense). Ainsi, au printemps, à la faveur des vents, les eaux peuvent-elles se mélanger, et les eaux du bas riches en nutriments remonter pour se mêler à celles du haut pleines de plancton et d’oxygène. « Il faut des températures hivernales extrêmement basses en parallèle avec des épisodes venteux, mais dans un contexte de changement climatique, les hivers deviennent de plus en plus doux. On n’aura peut-être plus d’hivers froids pour permettre ce brassage. Ça a déjà un impact sur tout l’écosystème, la biologie des poissons et même, l’oxygène : le fond du lac est aujourd’hui asphyxié. » Les efforts de la Cipel et des collectivités avaient permis au lac Léman, autrefois très pollué (quand l’auteur de ces lignes étudiait l’ingénierie de l’environnement à l’université de Lille, au débit des années 1990, le lac était un exemple de mauvaise gestion) de redevenir bien propre, ceux du changement climatique perturbent son fonctionnement biologique et physico-chimique.

On ne va pas forcer les eaux à se mélanger, parce qu’on ne va pas faire tourner des hélices dans le lac. Alors, on se contente d’observer pour imaginer des solutions, ensemble. Directrice de l’Institut des sciences de l’environnement et codirectrice de la chaire Unesco-Hydropolitique pour l’Université de Genève, Géraldine Pflieger loue le succès de la Cipel, qu’elle assimile à de la science participative avant l’heure : « aux prémices même de toute cette action, il y a eu une coopération forte entre des acteurs qui étaient à la frontière entre la science et l’action, parce que la situation de sauvegarde du Léman l’exigeait à l’époque : la Cipel a fait un travail extraordinaire dès le début, avec des outils qu’on appelle aujourd’hui science participative. » À l’époque des jeunes avaient pris leurs petites éprouvettes pour analyser la qualité de l’eau des affluents du Léman, cela permit de dresser les premières cartes de pollution, et d’établir la gravité de celle-ci. « Ça a été un véritable déclencheur de l’action parce que cela a conduit à engager tout un programme à l’échelle de ce très vaste bassin, qui a abouti à une reprise complète de la qualité de l’eau de surface sur l’ensemble du bassin lémanique. » Mer intérieure, le Léman est une Méditerranée à l’entrée des Alpes. Soixante ans après la création de la Cipel, les résultats sont là : les taux de phosphore ont baissé et on peut se baigner.

Difficile prévention

Il semblerait pourtant qu’il faille recommencer car après le phosphore, après la moule quagga qui colmate le réseau de chaleur « écologique » de la bonne ville de Saint-Gingolph, dont Madame Pflieger est la maire – de l’eau captée dans le lac alimente une sorte de pompe à chaleur géante qui apporte aux bâtiments publics et à la moitié des familles chaleur en hiver et fraîcheur en été, voici à nouveau les blooms : « il y a à nouveau des explosions d’algues, comme celle de septembre 2022. Des Uroglena, pas toxiques, mais problématiques. Heureusement que le Cipel était là car il a permis une coordination de tout le monde à l’échelle du lac. » Après. Pourquoi la bonne gouvernance de la Cipel n’a pu permettre de prévoir ce qui pouvait se passer, alors que l’événement a été déclenché par un glissement de terres, autrement dit, par l’arrivée brutale dans les eaux du lac de nutriments portés par des sols… alors que le glissement d’une couche de terres est assez prévisible. « On n’a vu cela qu’a posteriori, il faut reconnaître », admet Nicole Gallina. Depuis lors, les sols sont un peu plus observés, comme la chlorophylle : les élus riverains devraient demain pouvoir être prévenus quelques heures plus tôt de l’imminence de l’explosion démographique d’une algue. Il faut toujours des éléments marquants pour avancer, et prévenir… ce qui est déjà advenu. Un modèle numérique a d’ailleurs été développé, il porte le nom d’une série télé, SWAT (Soil and Water Assessment Tool). Ce modèle, explique Nicole Gallina, « permet de modéliser l’hydrologie du territoire en prenant en compte notamment l’usage des sols et le changement climatique. » SWAT est un modèle d’évaluation du risque érosif autant que de la qualité et de la quantité d’eau dans un bassin-versant, selon la manière dont on modifie l’aménagement du territoire.

Un jour, il faudra s’occuper des débits

Il lui est difficile de prévenir, la Cipel a aussi un problème de coopération côté France. Les collectivités locales sont peu ou mal associées, ce dont témoigne Géraldine Pflieger, en tant que maire de sa commune. « Il manque une dimension multi-échelles, cette façon d’associer les acteurs du territoire qui est très bien faite sur la rive nord du lac, pas assez sur la rive sud. » Il manquerait également une dimension quantitative car la Cipel ne s’occupe « que » de la qualité de l’eau. Or, le travail sur la quantité, sur les débits, est celui des agences de l’eau. C’est dommage, car comme le rappelle Bruno Forel, président du Syndicat Mixte d’Aménagement de l’Arve et de ses Affluents (SM3A), « la moitié de l’eau présente à Arles, dans le Rhône, lors de l’étiage, provient du Léman, qui joue donc un rôle tampon. Il y a interdépendance entre le fleuve et le lac, entre des bassins différents. » Et puis, les problèmes de qualité de l’eau peuvent également survenir après des soubresauts de débits. Une inondation, une crue, cela peut altérer de loin en loin ce qui coulera du robinet. Il faudrait donc envisager une extension des prérogatives de la Cipel, c’est-à-dire, marcher sur les pieds des agences de l’eau.

Ailleurs, où il n’y a pas d’agences, cela se fait. Dans le monde, on trouve beaucoup d’exemples de structures de gestion transfrontalières d’un fleuve ou d’un bassin-versant. Conseiller spécial du président (Louis Fauchon) du World Water Council, Guy Fradin les connaît aussi bien qu’il a l’habitude des institutions françaises : ingénieur des eaux et forêts, il a été directeur général de l’Agence de l’eau Seine-Normandie jusqu’en 2011 avant de présider le conseil d’administration de l’Agence de l’eau Rhin-Meuse et l’Observatoire environnemental du canal Seine-Nord-Europe. « Ce qui compte dans une bonne gouvernance, c’est la transparence des institutions, de leur fonctionnement, le rassemblement de l’ensemble des acteurs, le partage des connaissances, un bon financement et une grande cohérence. » Tout cela ensemble. Pour penser ensemble des bassins-versants, l’amont et l’aval, la source et le fleuve, il faut au moins que tout le monde soit d’accord sur les enjeux. « On ne peut pas avoir un pays pour qui l’important c’est la santé, qui doit s’occupèrent d’un fleuve avec un autre pour qui l’important c’est le rural. La hiérarchie des usages doit être la même. » La cohérence des visions, c’est ce qu’il y a de plus compliqué à établir. Elle existe peu ou prou sur le Rhin, le Danube, le Mékong et même le Nil. Elle est discutable sur le Jourdain et n’existe pas à propos du Colorado où la seule cohérence qui règne est celle du chacun pour soi. Géraldine Pflieger cite un bon millier d’accords multilatéraux ou bilatéraux sur l’eau dans le monde, à mettre en regard des 7 ou 8 conflits vraiment repérés dans l’histoire récente de notre planète autour de la ressource en eau. La guerre de l’eau, tarte à la crème médiatique, est un fantasme.

Ne pas oublier les gens…

La bonne gouvernance doit être cohérente à tout point de vue, abonde Jessica Bergstein-Colet, chef de projet à l’association Initiative pour l’avenir des grands fleuves, créée par Erik Orsenna. Elle ajoute le fleuve Sénégal à la liste des exemples de bonne gestion interétatique, partagée entre le Sénégal, la Mauritanie, le Mali et la Gambie. « Parce que tout n’est pas acceptable, dès lors qu’on parle d’eau, il faut expliquer, réexpliquer, toujours expliquer, il faut qu’il y ait un dispositif de sensibilisation mis en œuvre, déjà pour que la vision politique permette d’être instillée à tous les échelons… » Sans acceptation des gens, la meilleure des gouvernances ne sert à rien d’autre qu’à faire des séminaires et des colloques. « Si les populations locales ne s’approprient pas les projets qui les concernent, rien ne peut être fait, en tout cas de façon durable. » Il en va de l’eau comme du vent : les projets d’éoliennes sont souvent rejetés par des populations qui estiment n’avoir pas été consultées en amont, mises devant le fait accompli. L’association fondée par Erik Orsenna est un réseau d’acteurs pluridisciplinaires, d’experts en sciences humaines et sociales, des ingénieurs, des hydrologues, des gestionnaires de ports, qui se réunit régulièrement quelque part sur la Terre pour partager regards, connaissances et solutions de terrain. « Les fleuves sont des artères, ce sont par eux que sont charriées toutes les pollutions, ce sont en eux que se trouvent aussi les solutions. Ce sont des patrimoines, certes, des biens communs, qu’on se doit tous de préserver ensemble, et pour cela, il est indispensable de partager, effectivement, quelles que soient les échelles, une vision politique, » jusqu’aux citoyens, aux usagers premiers de l’eau qui s’écouleraient.

… ni les zones humides !

Christian Schwoeher est le directeur du Conservatoire des espaces naturels de Haute-Savoie. La sensibilisation, il en fait chaque jour à propos des zones humides, dont la plupart d’entre nous ont oublié la définition et l’intérêt. « Il y a une attention particulière apportée au niveau des zones humides dans ce département. On a aussi leur prise en compte dans différentes démarches, que ce soit les SAGE ou des contrats de milieux [ou de rivière], et ça peut se décliner derrière sur des travaux de restauration. Toute la question, en définitive, c’est comment les zones humides sont prises en compte le plus en amont possible, notamment en lien avec les Scot : plus les zones humides sont prises en compte en amont, plus elles sont intégrées dans la planification, plus il y a de relais et de prise en considération. » Il s’agirait que les tourbières deviennent un élément d’aménagement du territoire, estime Christian Schwoeher. On en est loin. Les élus semblent toutefois l’avoir compris, grâce notamment à l’action des agences de l’eau.

Chez les agriculteurs ça progresse aussi, en particulier chez les éleveurs. « Il y a en ce moment une discussion sur les conditions des règles de préservation des milieux humides et des tourbières dans le cadre des critères de conditionnalité de la PAC. Demain, quel sera le niveau de prise en considération des milieux humides, étant donné qu’on va peut-être les restreindre à des habitats communautaires, comme les tourbières, c’est-à-dire à des sites protégés, ou à des sites labellisés Ramsar. Derrière cette question il y a celle de la connaissance : où sont les zones humides [communes] ? » Très importantes dans les têtes de bassin, c’est-à-dire dans le chevelu hydrographique de ruisseaux qui amènent l’eau des sources aux rivières, les zones humides sont des tampons en cas de sécheresse et de grands abats d’eau. Elles ne sont pas que des musées de biodiversité à couvrir d’une cloche de protection : ce sont des espaces utiles, presque tous situés en zones de production agricole. Une des difficultés est que leur définition légale est complexe, car elle nécessite à la fois de l’observation de terrain et un sérieux travail de pédologie. Ce n’est pas parce qu’il y a de l’eau qui stagne au milieu d’un champ qu’il y a zone humide, cela peut-être simplement de l’eau de pluie qui ne peut s’échapper car le sol a été tassé par un engin ! Les bureaux d’études se trompent dans un cas sur deux, en France. « On n’est pas en capacité de savoir quel est l’état des lieux de nos zones humides au niveau national, alors qu’on a a priori tous les outils, le spatial ou autres. » Le satellite observe une suspicion de zone humide, pas une zone humide. Photo en main, il faut aller vérifier sur le terrain. Lequel est souvent un terrain agricole, travaillé par un exploitant qui a parfois perdu la mémoire de ce qu’est une zone humide.

Guy Fradin et Jessica Bergstein-Colet rebondissent de concert sur les propos de leur collègue de Haute-Savoie. « Les zones humides, c’est l’exemple typique de la cohérence entre la politique de l’eau et la politique agricole. Or, en France, dans un contexte de politique agricole qui est à la fois nationale et communautaire, la cohérence entre la politique environnementale, la politique de l’eau et la politique agricole n’est pas assurée, ni au niveau national ni communautaire. Donc, beaucoup d’agriculteurs sont pris dans ces contradictions, » et ne se préoccupent pas plus de leurs tourbières que de leurs haies. D’autant que la vie est dure : on peut sensibiliser autant qu’on veut, si l’agriculteur qui a du mal à vivre de son travail n’a aucun intérêt économique à ne pas drainer sa tourbière, on ne voit pas pourquoi il les garderait, à moins qu’on ne l’incite financièrement à le faire.

Quand le secouriste aura-t-il l’information en temps réel ?

Pour Géraldine Pflieger, un des intérêts majeurs du satellite est celui du « downscaling », de la descente d’échelle, en français pas tellement plus compréhensible : avec la machine qui tourne, on peut aujourd’hui à la fois disposer d’une vision large des choses et regarder par le trou de la serrure. « On peut aller voir les acteurs locaux, des agriculteurs, des pêcheurs, des élus pour leur montrer les changements à l’œuvre chez eux, » en les comparant avec ailleurs. Le satellite fait un lien entre le global et le local. Son intérêt, finalement, c’est de produire une aide à la décision. Par des gens de terrain, rappelle en conclusion Guy Fradin : « les données doivent toujours être validées, elles doivent être interprétées, elles doivent être croisées, modélisées, utilisées et elles doivent être confrontées à la réalité de terrain quand elles viennent d’en haut. » On aura toujours besoin de techniciens et d’ingénieurs pour développer un regard d’ensemble et interpréter les données venues d’en haut. En particulier lorsqu’elles sont censées éclaire la décision à l’occasion d’une crise majeure.

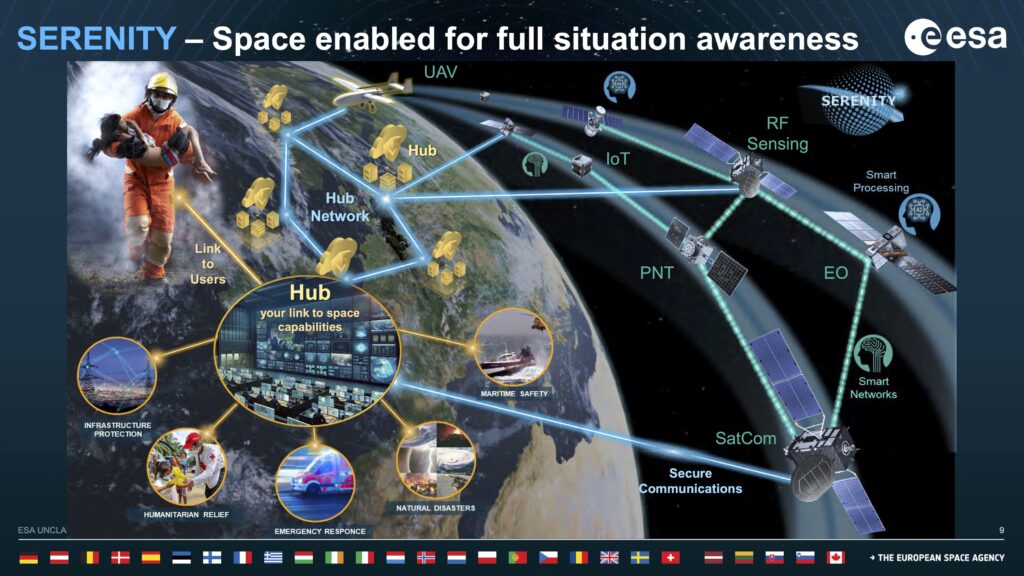

Elle a bien failli être astronaute, elle est officier de marine de réserve et directrice à l’ESA (« conseillère senior ») où elle s’occupe en particulier des réponses aux crises. Isabelle Duvaux-Béchon indique sans fard un problème : les satellites ne dialoguent pas entre eux, et trop peu avec les personnels précipités sur le terrain… « Vous savez, il n’est pas intelligent le satellite, il va prendre des images, envoyer des données, mais il reste l’humain, que ce soit pour fabriquer le satellite ou pour l’utilisation de ses données. » Petit rappel : l’ESA, c’est l’Europe plus la Suisse, le Canada, le Royaume-Uni et la Norvège. L’ESA envoie des satellites pour le compte de ses clients, lesquels peuvent passer par d’autres agences du monde pour envoyer d’autres satellites dans l’espace, tout cela fait un beau petit monde en orbite. Toujours ponctuel, toujours en retard : les satellites d’observation ne sont pas géostationnaires, alors ils passent et repassent au-dessus du même endroit à la même heure, tous les x jours, durant le même laps de temps. « Vous obtenez les informations du satellite deux jours après les avoir demandées, au mieux, car en cas de crise majeure ça peut être un peu plus long. » On peut faire moins avec le système Copernicus (qui a permis de rationaliser la collecte et la diffusion de données satellitaires sur l’environnement et les crises), atteindre six heures, mais six heures, c’est déjà trop tard, surtout quand on prétend suivre depuis là-haut un incendie de forêt gigantesque. « Le vrai problème en cas de crise c’est d’avoir une information de suite, au moment où elle est nécessaire. Mais pour cela, c’est toute la chaîne qui doit réagir entre le moment où l’image va être prise et le moment où les informations traitées par des êtres humains ou par l’intelligence artificielle vont arriver sur le terminal du pompier ou du spécialiste de protection civile ou du centre de gestion de crise. »

Une charte internationale « espace et catastrophes majeures « a été signée en septembre 2000 entre 17 agences spatiales et 7 sociétés fournisseurs de données (provenant de 270 satellites), afin d’être à même de fournir des images le plus rapidement possible après sollicitation d’un État. Ce fut le cas le 12 octobre avec le Sri Lanka embarrassé par des inondations. L’information peut être délivrée plus vite, elle n’en restera pas moins entachée de biais, masquée par exemple ici et là par des nuages qui interceptent la lumière renvoyée par le sol, créant des secteurs tout blancs sur les images. Pour pallier, il peut être demandé à un autre satellite, radar, de se pencher sur le problème. Uniquement s’il se promène dans la même zone orbitale, car on ne peut demander à un satellite de sauter d’une orbite à l’autre, ce qui coûterait une fortune en carburant. Heureusement, beaucoup de satellites se suivent sur une même orbite… à distance de quelques heures. « Vous comprenez que si vous voulez avoir une image en un claquement de doigts, il vous faut beaucoup, beaucoup de satellites, et puis il faut les systèmes qui vont avec pour permettre d’acheminer les données et les traiter. » L’image doit être interprétée avant qu’elle n’arrive au pompier, car celui-ci n’aura jamais le temps d’y réfléchir. En cas de crise, des spécialistes doivent être là pour épauler les secours, pour leur délivrer des informations vraiment utiles. Pour leur indiquer, par exemple, à partir d’images d’inondations et d’autres données satellitaires, le nombre de bâtiments encore secs, le nombre de bâtiments détruits, le nombre de bâtiments inondés, l’état des routes, celles praticables pour les engins de secours etc.

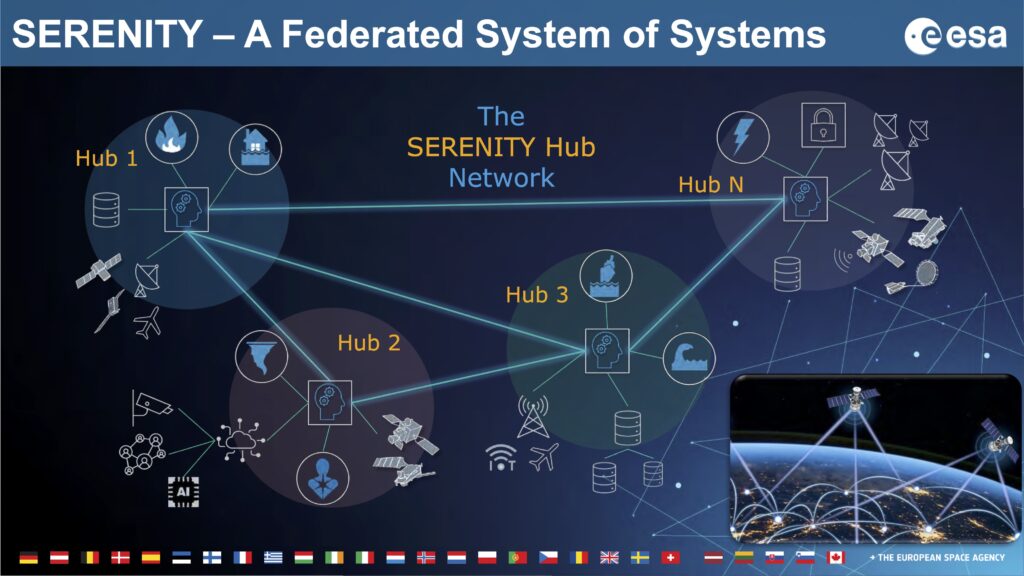

Le difficile dialogue des satellites

Encore faut-il que ces informations parviennent au ras de la Terre. Or, sur le terrain, lors d’une crise majeure, les réseaux de télécommunications sont en général détruits ou fonctionnent très mal. Comment alors recevoir des images à haute résolution qui exigent une large bande passante ? Heureusement, même là où il n’y a plus rien, il y a toujours au-dessus des satellites de télécommunications qui tournent. Mais de modèles, de nationalités et donc de standards et de protocoles différents… Les satellites ne communiquent pas tous entre eux, et si d’aventure le terminal du pompier n’est pas compatible avec certains protocoles, il ne pourra pas recevoir grand-chose. La transparence du téléphone mobile et l’universalité de l’Internet nous ont habitués à la simplicité. Or, en matière de données satellitaires, le bordel règne. Voilà pourquoi l’ESA a proposé il y a deux ans une initiative pour que l’ensemble des moyens spatiaux – et aériens (drones) – sachent se parler de manière que le pompier, sur le terrain, reçoive une information sans avoir à se demander à qui il doit la demander, ni pour combien. « C’est toujours pareil, que voulez-vous, chacun travaille en silo, chaque agence dans son agence, chaque fabricant avec son matériel, chaque spécialiste d’un satellite n’en connaît pas d’autres etc. » L’humanité aime se répartir en casiers, l’ESA espère les rendre transparents, au moins à l’occasion de crises majeures. Pas seulement les grands casiers des grandes organisations, toutes les séparations : « il faudrait conférer à un centre de gestion de crise la capacité à n’importe quel moment non seulement de récupérer de l’image interprétée, mais aussi tous les autres médias, que ce soit la télévision, la personne qui est sur place et filme avec son téléphone et poste sur les réseaux, l’internet des objets, les senseurs connectés qui mesurent par exemple la hauteur d’eau ; bref, toutes ces informations-là devraient pouvoir être récupérées de façon à être intégrées à un flot d’informations interprétées en plus des images satellitaires. » Ajoutons les HABS (High Altitude Pseudo Satellite), c’est-à-dire des ballons que l’on peut envoyer à tout moment à 20 km d’altitude pendant 2 ou 3 mois au-dessus d’une zone. « Tout cela, ce sont des systèmes qui n’ont pas été conçus pour se parler, il faudra qu’ils puissent le faire, ou qu’ils parlent à un orchestrateur commun et qu’on mette en place aussi toute la gouvernance au sens de qui a accès à quoi, quand et à quel prix. »

Cela s’appelle serenity pilot implementation, en langage Duvaux-Béchon. Dans l’idéal, « le pompier une fois sur le terrain précisera sa demande auprès d’un système – on va appeler ça une place de marché digital, qui lui dira par exemple que pour cette demande-là, voilà ce qu’on peut vous proposer, et ça va vous coûter tant : une image dans les 15 minutes d’un satellite privé sera payante (OneWeb, ICEYE etc.), mais si vous pouvez attendre une demi-heure, vous allez avoir une image gratuite d’un satellite étatique, par contre ça coûtera quand même un peu parce qu’il faut compter le traitement derrière de l’image. » La proposition de l’ESA en est aujourd’hui à identifier les « trous capacitaires, » les manques, les besoins en services, en technologies ou en développement. Chaque État membre de l’ESA s’occupe d’un manque identifié, pour éviter que chacun ne fasse la même chose dans son coin. Premières démonstrations en 2025 au sujet des feux de forêt, de la surveillance maritime et même, de la gestion de crise dans un stade. « Oui, en quoi les satellites peuvent aider lors d’une crise de type terrorisme : mobiliser un système de télécommunication parce que les terroristes auront coupé les télécoms sur place, s’assurer depuis l’espace que les voies d’accès pour les forces de police sont bien dégagées etc. »

De l’utilité des réseaux sociaux

Le chantier semble considérable. Sur son incendie, le pompier a besoin de prévoir l’avancée du front de flammes, à partir d’informations sur les vents, la température et le degré d’hygrométrie de l’air, sur le type de végétation, son niveau d’assèchement et celui du sol. Il a besoin d’évaluer les risques, donc de données sur les habitations, les bâtiments, qui ou quoi est dedans par exemple à partir du nombre de téléphones actifs dans la zone d’intervention. Les téléphones sont d’ailleurs un bon indicateur de l’ampleur d’une catastrophe : lorsqu’aucun n’est détecté, c’est que les batteries sont vides et qu’il n’y a plus un électron pour les recharger. Le pompier devrait pouvoir disposer de données, d’images rafraîchies toutes les demi-heures. Ça ne sera possible selon la conseillère senior de l’ESA qu’à partir du moment où l’on aura rendu tous les satellites et tous les systèmes de communication interopérables, et que les images et les données puissent être interprétées bien en amont, avant que le pompier ne les reçoive, en les interpolant avec des données issues d’autres mondes, dont les réseaux sociaux : « quand on parle d’une crise ou d’un événement qui se passe quelque part dans une ville, le fait d’avoir la photo de manifestants en train de se réunir quelque part, ou d’une route qui est coupée par un barrage ou un accident, ça va être fondamental, et même peut-être plus utile que d’attendre l’image satellite. » Isabelle Duvaux-Béchon se souvient d’une épidémie de grippe survenue il y a quelques années à l’est des États-Unis. L’information était arrivée plus vite par les médias sociaux que par le pourtant efficace Center of Disease Control d’Atlanta : les gens allaient sur Internet pour consulter les symptômes, tous les mêmes, les algorithmes ont fait le reste, et les autorités ont pu se rendre compte de l’ampleur du problème avant que leurs services ne les informent ! Cela tombait bien, les informations véhiculées par les réseaux étaient valides. Or, ils diffusent aussi énormément de rumeurs, d’informations infondées voire, fabriquées. Issues du satellite ou d’une éprouvette, les données nécessaires à la bonne gouvernance de l’eau doivent plus que jamais être croisées et interprétées.

Le Léman sur appli

Elles le sont de fait si elles sont nourries par les citoyens eux-mêmes. Par exemple dans le cadre du projet Lemanscope, qui récolte des données sur la qualité des eaux du Léman à partir des téléphones portables des gens. « L’idée est de sensibiliser, d’éduquer le public, qui ne le sera jamais assez, mais aussi… de mieux comprendre les variations saisonnières et spatiales de la qualité de l’eau sur l’ensemble du lac. » commence Laurence Glass-Haller, collaboratrice scientifique à l’École Polytechnique Fédérale de Lausanne, une des coordinatrices du projet. « On a les données satellites sur le lac, mais pour les valider, on a besoin des sciences citoyennes, d’observations in situ par les gens. » L’École polytechnique de Lausanne utilise également une plateforme fixe qui flotte sur le Léman, devant Lausanne, baptisée LéXPLORE. Un ponton de 10 m sur 10 m avec une centaine de capteurs sur laquelle les chercheurs se succèdent afin de recueillir des données objectives sur l’eau du lac Léman. « Avec le Lemanscope, on a en plus de cette plateforme quelque 2 000 points de mesures répartis sur la totalité de la surface du lac ! » Des milliers de points réalisés par des centaines de citoyens bénévoles. Et toute l’année, chaque jour et pas uniquement à 11 h 30 comme le satellite qui passe au-dessus du lac comme le facteur, toujours à la même heure. À l’heure où nous écrivons, 655 personnes participent au programme, ce nombre augmente chaque jour. Elles ont réalisé à ce jour 2 346 mesures, à peu près partout sauf au centre du lac, et plutôt côté suisse.

Comment cela se passe ?Que vous soyez à la nage, en bateau, en voilier, en kayak ou même, c’est plus hasardeux, sur un paddle, vous pouvez donc apporter des données au monde scientifique. Des données sur la qualité de l’eau, estimée par sa couleur, évaluée par l’appareil photo du téléphone portable. Toute se passe via une application qui s’appelle EyeOnWater. « Une fois l’application chargée, il suffit de prendre une photo selon un protocole précis : à l’ombre ou dos au soleil, sans vagues, téléphone bien à plat, autant que possible. Et on indique la couleur que l’on voit, à partir d’une échelle qui en comporte 21, » l’échelle de couleurs de François-Alphonse Forel, un savant suisse mort en 1912, un standard dans le monde de la recherche. Voilà pour les teintes allant du bleu au vert.

En ce qui concerne la transparence, le public connecté peut vraiment jouer au chercheur : un disque de Secchi lui est proposé. Connu des étudiants en biologie, cet engin est donc un disque blanc, suspendu à un décamètre souple. On le plonge dans l’eau, et on note la profondeur à partir de laquelle on ne le distingue plus. « On l’envoie par la Poste aux participants ! » Le disque donne une idée de la turbidité de l’eau, donc de la présence de particules en suspension, du phytoplancton, etc. Inventé en 1865, cet outil simple n’a pas été démodé par le satellite. « En hiver, en général, on a des Secchi à 10 m, voire à 17 m. En été, on remonte à 2,5 m. » Plus il y a de plancton, plus l’eau est verte, moins elle est transparente. Et inversement en été, avec la couleur bleue qui domine.

Toutes les six semaines, les organisateurs proposent aux participants du Lemanscope des visites sur la plateforme LéXPLORE, ainsi que des webinaires et des ateliers pour maintenir la motivation qui a tendance à suivre la courbe des températures : quand il fait froid, il est plus difficile d’avoir des observations. « Cela permet aussi à cette communauté de discuter avec les scientifiques sur les problématiques du lac, sur leur perception de la qualité de l’eau, sur leur expérience science participative. » Des participants qui ne sont pas mauvais : d’après Laurence Glass-Haller, ils ne feraient que 15 % d’erreurs. C’est beaucoup, mais pas si mal, d’autant que le satellite lui aussi se trompe : en dessous de 10 m, il ne peut plus mesurer convenablement la transparence et puis, l’analyse des données a prouvé que le satellite est perturbé dans la partie genevoise du lac, ce qu’on appelle le « Petit lac » : « Apparemment, ce serait un problème de brouillage des signaux optiques, parce qu’en fait, le Petit lac est plus étroit, on est plus proche des rives, et la réflectance est plus grande. » Un biais qui peut cela dit s’appliquer aux observations des gens, car « pour les mêmes raisons, on voit que les observations proches des rives sont légèrement moins bonnes que celles prises à plus de 1 km des rives. » Démarré il y a six mois, le projet Lemanscope va durer vingt mois. Il a déjà montré son intérêt : outre la motivation des citoyens amoureux de leur Lac, la masse importante de données contrebalance les erreurs de mesures, et démontre que des citoyens non scientifiques peuvent en termes de qualité de travail s’approcher de la rigueur des chercheurs et de celle du satellite. Et leur fait gagner du temps.

Suivre les blooms

Disque de Secchi ou caméra embarquée sur un satellite, les chercheurs sont capables de dresser régulièrement des cartes de transparence de l’eau et de biomasse planctonique. Frédéric Soulignac, par exemple. Cet ingénieur à l’INRAE travaille avec Géraldine Pflieger sur la modélisation des explosions démographiques d’algues, les fameux « blooms » qui arrivent encore à surprendre tout le monde, en dépit de tous ces appareils braqués sur le lac Léman. « On n’arrive pas à anticiper parce que la vie, c’est complexe ! On ne sait pas tout… On arrive juste à bien reproduire la succession saisonnière des différentes espèces dans le lac avec, au printemps, plutôt des diatomées dans les eaux de surface, et puis, au fur et à mesure que les eaux de surface perdent en nutriments, on a un développement en profondeur d’autres espèces. Par contre, on n’arrive pas à reproduire des événements particuliers comme ce bloom de septembre 2021 [celui des Oroglena sp.] où, en deux, trois jours, on a eu une explosion de la biomasse. » Le satellite permet à Frédéric Soulignac de suivre l’état global du phytoplancton. Il lui donne chaque jour l’état initial… de la veille, vu que le satellite ne passe qu’une fois par jour, à la même heure. « Et puisque l’on connaît bien les courants du Léman, à partir de là, s’il y a un bloom photographié, je peux prévoir sa circulation dans le lac, sur trois à quatre jours. » Une modélisation utile pour les élus qui pourraient décider la fermeture d’un point de captage lacustre de leur réseau d’eau potable.

Il existe une multitude de facteurs expliquant la survenue d’un bloom, mais le seul finalement que maîtrisent à peu près les chercheurs est le mouvement de l’eau, la courantologie. Et cela tombe bien, elle est assez stable. Sauf en vertical : « On voit que la stratification thermique s’intensifie avec le réchauffement climatique. On a une différence de température entre la surface et le fond qui est plus élevée. On a en conséquence un lac plus stable, qui est plus résistant à des tempêtes. » Or, ce sont elles qui obligent les couches d’eau à se mélanger, à faire se rencontrer algues et nutriments. « La stratification atténue la circulation verticale de l’eau, ça déconnecte les eaux du bas des eaux du haut. Les nutriments restent en bas. » Ce qui devrait empêcher les blooms ! « Certes, mais ce sont des bombes à retardement, tous ces nutriments, tout ce phosphore qui s’accumule au fond du lac. » Apparaissant et croissant au printemps et en été, les algues meurent, tombent au fond où elles entrent en décomposition. Aux dépens de l’oxygène, consommé par les bactéries à l’œuvre, au profit du phosphore, produit par la décomposition, qui reste donc sur les fonds. « Or, normalement, en hiver, avec le refroidissement de l’atmosphère, les eaux deviennent froides et comme elles sont plus denses, une convection verticale se met en place, » elles descendent, remplacent les eaux du fond qui remontent, « avec le réchauffement climatique, on s’attend à ce que ce brassage soit de moins en moins profond. » Par-dessus le marché, la moule quagga redistribue elle aussi les nutriments. « Elle se développe au fond, pas dans l’eau ; par son activité filtrante, elle redirige donc les nutriments là où elle se trouve, vers les zones littorales et au fond du lac. Cette moule est désormais la maîtresse du phosphore dans le lac », comme l’est par endroits la crépidule, gastéropode invasif sur côtes de Bretagne.

Le cube intelligent

Grégory Giuliani [dont j’ai fait le portrait dans Marianne le 18 mai 2025] est maître de conférences « senior » à l’université de Genève, au sein de l’Institut de l’Environnement (qui regroupe 130 chercheurs de tout domaine, droit, sciences, économie, management, de l’université de Genève). Selon lui, en dépit de leur qualité (et souvent, de leur gratuité), 93 % des images issues des satellites n’atteignent en définitive pas leurs cibles. « Al Gore, déjà en 1998, disait, à propos du programme américain d’observation de la Terre que la majorité de ces images satellitaires n’avaient allumé aucun neurone d’un être humain sur cette Terre. Et on s’est dit, avec un groupe de collègues, qu’il fallait qu’on maximise l’utilisation de ces données satellitaires au niveau national. » Ils ont alors construit le Swiss Data Cube, une infrastructure technique qui collecte l’ensemble des données de dix satellites américains et européens surla Suisse. Et un peu la France, l’italie, le Lichtenstein et l’Allemagne, vu que les orbites sont inclinées, la focale des satellites déborde donc sur les frontières. « Cela fait environ 3 000 milliards d’observations engrangées, 80 000 images, pour pas très cher », environ 40 millions d’euros. Le programme existe depuis 1984, il couvre l’ensemble des problématiques liées à l’environnement : l’évolution de l’enneigement, l’impact des sécheresses sur le réseau hydrographique, l’identification des poussières atmosphériques afin de prévoir les niveaux de pollutions en microparticules, ou encore la caractérisation des espaces artificialisés par le niveau… la densité de leurs végétations. « Le Cube a permis de montrer l’arrivée de végétations de type méditerranéen en Suisse et la dégradation des terres : on a pu montrer que celle-ci est deux fois supérieure à ce qui est officiellement rapporté par le gouvernement suisse. » La dégradation des terres est évaluée en mesurant les changements de couverture du sol ou de productivité des terres, cette dernière étant basée sur le calcul de l’évolution de la productivité photosynthétique sur une année. Cette (nouvelle) bonne connaissance de l’érosion des sols n’a pas pour autant fait réagir le gouvernement fédéral suisse. « C’est un petit peu frustrant, » reconnaît le chercheur.

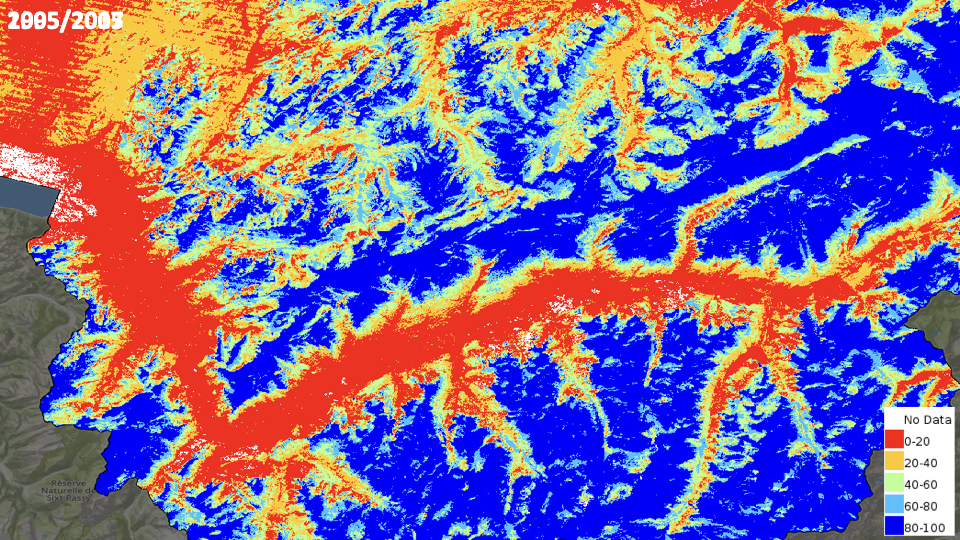

C’est en réalité un peu plus que cela, à propos de l’évolution de l’enneigement. Sur une carte des Alpes, à l’est du lac Léman, on voit comme un réseau sanguin rouge qui semble alimenter un tissu bleu. C’est une photo satellite. « En rouge, les endroits où il y a de la neige durant 0 à 20 % du temps en hiver. En bleu, 80 à 100 % du temps. On a comparé cette image toute récente avec d’autres, prises des années auparavant. On a ainsi pu démontrer que la zone rouge, c’est-à-dire le niveau où on trouve peu de neige, remonte en altitude. Et que les zones bleues, bleu foncé en particulier, ont diminué. On a pu quantifier cette diminution et faire une carte qui montre les zones de gains et les zones de pertes à travers le pays sur ces 20 dernières années. » Cette carte, la voici : la Suisse est ponctuée de rouge et de vert. En rouge, les endroits où l’enneigement a baissé, largement majoritaires ; en vert, au nord et au sud de la confédération, les lieux où au contraire, la neige continue de tomber. « On a déjà perdu presque 5 % de neige permanente à l’échelle du pays. Ça fait quand même quelques milliers de km² ! Et on a logiquement une augmentation proportionnelle des zones où pendant les mois d’hiver la neige est rare, de l’ordre de 8 %. » Les prévisions indiquent un avenir potentiel avec 40 % de neige en moins en 2080, à moins que l’on ne parvienne à freiner la hausse des températures à 2,5 °C, auquel cas la baisse ne, serait que de 20 %. « Toutes les stations de ski installées sous les 2 000 m sont a priori condamnées, » conclut Grégory Giuliani, qui hormis justement chez les gestionnaires de station, n’a pas perçu de grand intérêt parmi ses interlocuteurs, en particulier les élus.

Son laboratoire a également travaillé avec Danone au sujet de son impluvium. À partir de photos satellites et de données de terrain « participatives, mais aussi des relevés déjà faits par le passé. On a entré tout cela dans le Cube, on a généré ce qu’on appelle des séries temporelles sur la végétation, l’eau, le bâti etc. On a mixé le tout et on l’a injecté dans un petit truc qui est à la mode maintenant, l’intelligence artificielle. Et, à la fin, on a obtenu une carte qui montre » les différents types d’usages des sols, sûre à 92 %. Chaque pixel mesure 10 m sur 10 m. Chaque année, Danone peut voir l’évolution de son impluvium en observant les changements très précis de couleur. En bleu clair, les zones humides. En gris, les terres artificialisées. L’IA n’est pas un mot-clé, « elle est vraiment utile parce que les volumes de données sont tels qu’actuellement, les techniques qu’on utilisait dans le passé ne permettent plus d’extraire de manière pertinente l’information utile. » Sauf pour l’enneigement, sujet sur lequel l’intelligence artificielle ne marche pas, selon le chercheur suisse.